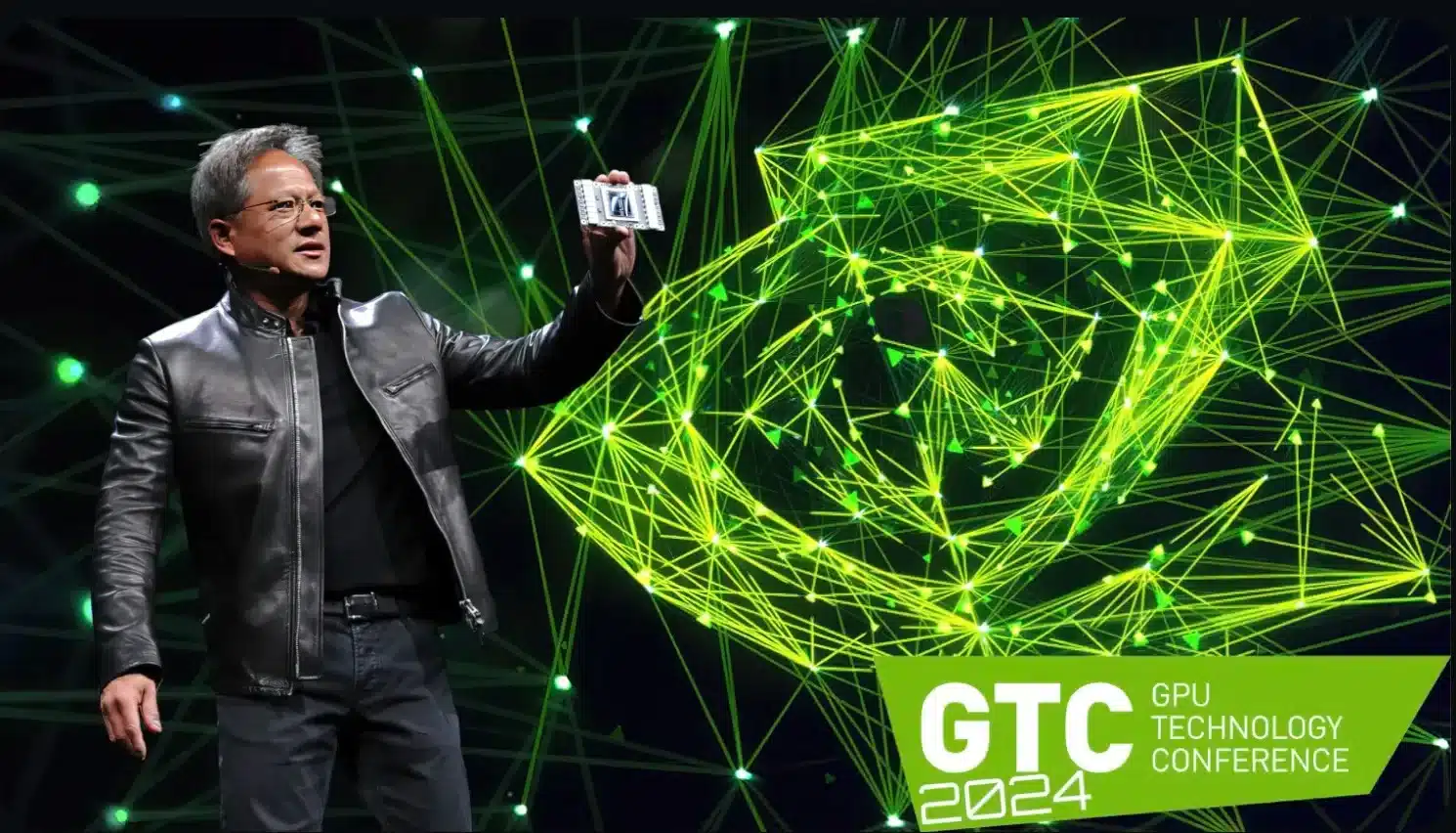

Como se esperaba, Nvidia presentó la nueva arquitectura Blackwell en la GTC 2024. Con el chip B200 y la plataforma GB200, el fabricante se adentra en nuevas esferas

Como era de esperar, Nvidia presentó la nueva arquitectura Blackwell en la actualGTC 2024 (Conferencia sobre Tecnología GPU)el lunes por la noche, prometiendo establecer nuevos estándares.

Como bien explicó el CEO de Nvidia, Jensen Huang, se pretende anunciar una «nueva era de IA generativa». La punta de lanza es el chip B200, que sustituye a los anteriores buques insignia H100 y GH100 de la generación Hopper

Las impresionantes especificaciones técnicas (ver más abajo) sugieren que grandes clientes como Amazon y Microsoft, con la demanda y el presupuesto correspondientes, harán cola en Nvidia para conseguir el mayor número posible de estos chips.

Lo más importante en pocas palabras

- Nvidia presenta la nueva arquitectura Blackwell para IA generativa en la GTC 2024.

- El chip B200 sustituye a los buques insignia H100 y GH100 y ofrece un rendimiento y una eficiencia energética mejorados.

- La GPU se basa en un proceso de fabricación de 4nm y cuenta con 208.000 millones de transistores.

- El superchip GB200 combina procesadores Grace y GPU Blackwell y ofrece una capacidad de cálculo extremadamente alta.

Datos técnicos del Nvidia B200

La GPU se ha desarrollado sobre la base del proceso de fabricación 4NP, un proceso de producción especial de 4 nm diseñado para Blackwell por el fabricante de chips taiwanés TSMC.

El propio B200 es un diseño de doble chip. Los dos chips incorporados se comunican a través de un enlace de deslizamiento a chip a una velocidad de hasta 10 Tbytes por segundo, por lo que no debería presentar desventajas en comparación con el proceso MCM (Multi Chip Module), utilizado principalmente por AMD.

Hay un total de 208.000 millones de transistores en la tarjeta B200. Según Nvidia, la potencia de cálculo teórica es la siguiente:

- FP8: Hasta 20 PetaFLOPS

- FP16: hasta 10 PetaFLOPS

- FP32: Hasta 5 PetaFLOPS

Según Huang, esto debería suponer unas cuatro veces más rendimiento en el entrenamiento de IA y 30 veces más rendimiento en la inferencia de IA. Además, la eficiencia energética se multiplicaría por 25.

En cuanto a la memoria, Nvidia B200 funciona con una memoria HBM3e de 192 GBytes, cuyo ancho de banda debería alcanzar los 8 TBytes/s.

«Grace Blackwell» como nuevo superchip

El nuevo chip también constituye la base del superchip «Grace Blackwell» denominado GB200, que se utilizará principalmente en el ordenador NVL72 de Nvidia y en soluciones personalizadas.

Haciendo honor a su nombre, el GB200 Grace Blackwell es una solución híbrida compuesta por un procesador Grace con 72 núcleos Neoverse V2 del fabricante Arm y dos de los chips gráficos B200 mostrados, por lo que un solo chip GB200 tiene cuatro troqueles en este sentido.

En el ordenador NVL72 mencionado anteriormente, se utilizan 36 de las CPU Grace junto con 72 GPU Blackwell (y, en consecuencia, 144 matrices Blackwell), lo que da como resultado los siguientes datos técnicos insanos:

- Procesador: 2.592 núcleos ARM Neoverse V2

- Memoria: hasta 17 TByte de RAM LPDDR5X

- 72 GPU Blackwellcon memoria HBM3e de 13,5 TBytes

Potencia de cálculo - FP4: hasta 1.440 PetaFLOPS

- FP8 potencia de cálculo: hasta 720 PetaFLOPS

- FP16 potencia de cálculo: hasta 360 PetaFLOPS

Gracias a NVLink, que promete hasta 130 Tbytes por segundo de ancho de banda, el superordenador NVL72 debería comportarse como un único procesador gráfico masivo

Un total de hasta 576 GPU pueden conectarse en un dominio NVLink de este tipo; según Huang, la potencia de cálculo total debería ser suficiente para procesar grandes modelos de lenguaje (LLM) con billones de parámetros.

El supuesto consumo de energía es correspondientemente alto: se dice que un solo superchip GB200 requiere hasta 2.700 vatios.

Los primeros clientes empresariales ya están haciendo cola La plataforma de IA debería estar disponible para los socios empresariales a lo largo del año. Nvidia menciona explícitamente a proveedores de la nube como AWS, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure, que, como era de esperar, están mostrando interés en la arquitectura Blackwell. Como explica Huang, Nvidia se enfrenta con Blackwell al «lanzamiento más exitoso de la historia de la compañía».