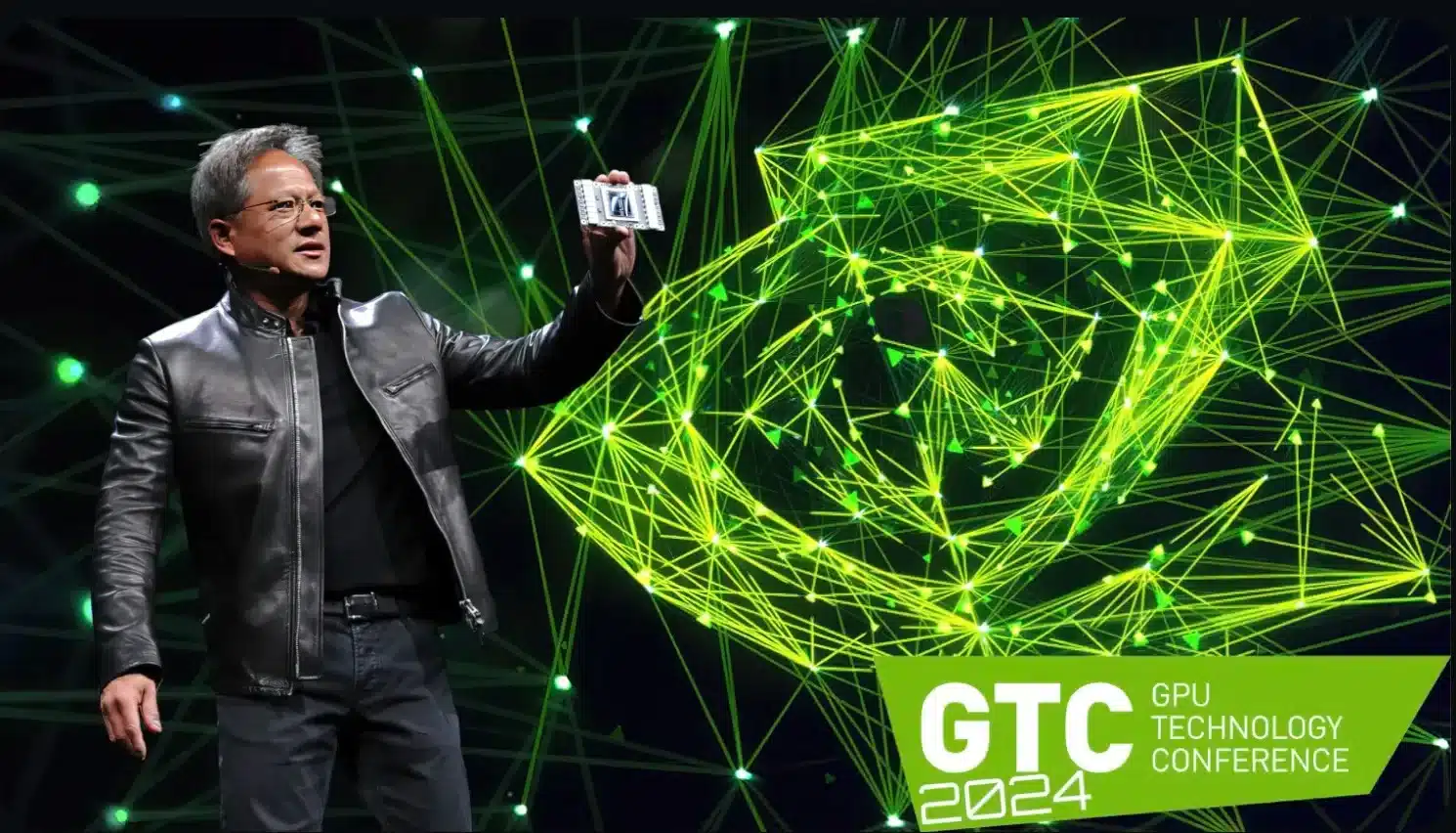

Comme prévu, Nvidia a présenté sa nouvelle architecture Blackwell lors de la GTC 2024. Avec la puce B200 ainsi que la plateforme GB200, le fabricant s’avance dans de nouvelles sphères.

Comme on pouvait s’y attendre, Nvidia a présenté dans la nuit de lundi à mardi, lors de laGTC 2024 (GPU Technology Conference)nouvelle architecture Blackwell, qui promet d’établir de nouveaux standards.

Les caractéristiques techniques impressionnantes (voir ci-dessous) laissent supposer que les gros clients comme Amazon et Microsoft, qui ont des besoins et un budget correspondants, feront la queue chez Nvidia pour obtenir autant de ces puces que possible.

L’essentiel en bref

- Nvidia présente la nouvelle architecture Blackwell pour l’IA générative lors de la GTC 2024.

- La puce B200 remplace les produits phares H100 et GH100 et offre des performances et une efficacité énergétique améliorées.

- Le GPU est basé sur un processus de fabrication en 4 nm et dispose de 208 milliards de transistors.

- La superpuce GB200 combine les processeurs Grace, les GPU Blackwell et offre une puissance de calcul extrêmement élevée.

Caractéristiques techniques du Nvidia B200

Le GPU est développé sur la base du processus de fabrication 4NP – c’est-à-dire une fabrication spéciale en 4 nm conçue pour Blackwell par le fabricant de puces taïwanais TSMC.

Le B200 lui-même est un modèle double. Les deux puces intégrées communiquent via une liaison Dia-to-Die à une vitesse allant jusqu’à 10 TByte par seconde et ne devraient donc présenter aucun inconvénient par rapport au procédé MCM (Multi Chip Module), principalement utilisé par AMD.

Au total, il y a ainsi208 milliards de transistorsdans la carte B200. Selon Nvidia, les performances de calcul théoriques s’expriment comme suit:

- FP8 : jusqu’à 20 pétaFLOPS

- FP16 : Jusqu’à 10 PetaFLOPS

- FP32 : Jusqu’à 5 PetaFLOPS

Selon Huang, cela devrait permettre de quadrupler les performances en matière d’apprentissage de l’IA et de les multiplier par 30 en matière d’inférence de l’IA. L’efficacité énergétique devrait quant à elle être améliorée d’un facteur 25

Du côté de la mémoire, Nvidia B200 fonctionne avec 192 Go de mémoire HBM3e, la bande passante devrait atteindre 8 TByte/s.

« Grace Blackwell », une nouvelle super-puce

La nouvelle puce est également à la base de la superpuce « Grace Blackwell » (GB200), qui sera principalement utilisée dans l’ordinateur NVL72 de Nvidia et dans des solutions personnalisées.

Le GB200 Grace Blackwell est une solution hybride composée d’un processeur Arm Grace à 72 cœurs Neoverse V2 et de deux des puces graphiques B200 présentées, ce qui signifie qu’une seule puce GB200 dispose de quatre dies.

L’ordinateur NVL72 mentionné ci-dessus utilise pas moins de 36 CPU Grace avec 72 GPU Blackwell (et donc 144 Blackwell-Dies), ce qui se traduit par les caractéristiques techniques délirantes suivantes:

- Processeur : 2.592 cœurs ARM Neoverse V2

- Mémoire vive : Jusqu’à 17 TByte LPDDR5X-RAM

- 72 GPU Blackwellavec 13,5 TByte de mémoire HBM3e

- FP4 puissance de calcul : jusqu’à 1.440 PetaFLOPS

- FP8-Puissance de calcul : Jusqu’à 720 PetaFLOPS

- FP16-Puissance de calcul : Jusqu’à 360 PetaFLOPS

Grâce à NVLink, qui promet jusqu’à 130 TByte par seconde de bande passante, le supercalculateur NVL72 devrait se comporter comme un seul processeur graphique massif.

La consommation d’énergie est donc élevée : une seule superpuce GB200 devrait consommer jusqu’à 2.700 watts.

Les premiers clients professionnels font déjà la queue Dans le courant de l’année, la plateforme IA devrait être mise à disposition des partenaires commerciaux. Nvidia cite explicitement les fournisseurs de cloud tels que AWS, Google Cloud, Microsoft Azure et Oracle Cloud Infrastructure, qui montrent sans surprise un intérêt pour l’architecture Blackwell. Comme l’explique Huang, Nvidia se trouve ainsi, avec Blackwell, face au « lancement le plus réussi de l’histoire de l’entreprise ».