予想通り、NvidiaはGTC 2024で新しいBlackwellアーキテクチャを発表した。B200チップとGB200プラットフォームにより、Nvidiaは新たな領域に参入している。

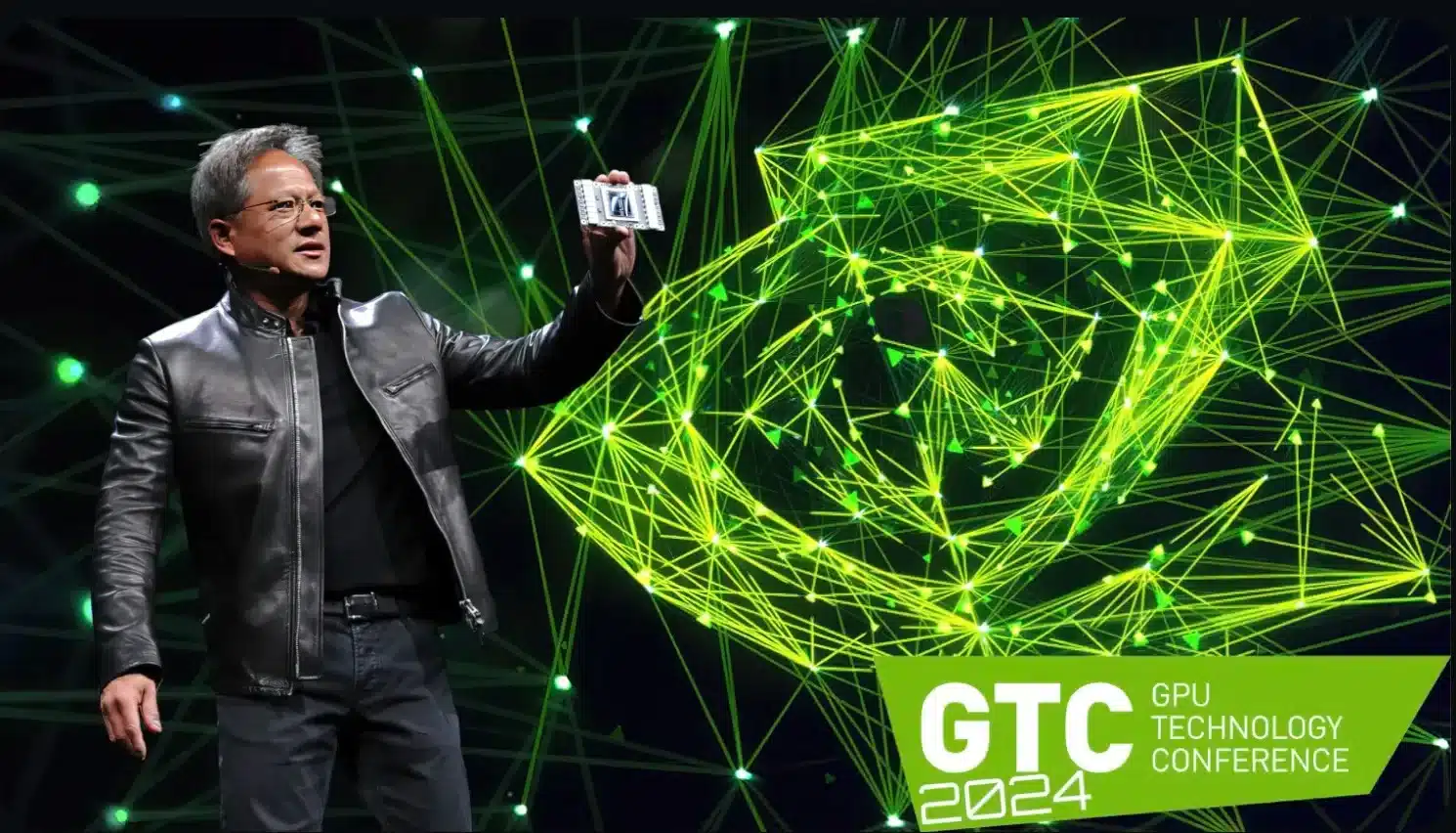

予想通り、Nvidiaは月曜日の夜、開催中のGTC2024(GPUテクノロジーカンファレンス)にて、新しいBlackwellアーキテクチャを発表し、新たなスタンダードを確立することを約束しました

。

Nvidiaのジェンセン・フアンCEOが適切に説明したように、これは「ジェネレーティブAIの新時代」の到来を告げるものである。その先陣を切るのがB200チップで、これまでのHopper世代のフラッグシップであるH100とGH100を置き換えるものだ

。

印象的な技術仕様(下記参照)は、アマゾンやマイクロソフトのような需要と予算に見合った主要顧客が、これらのチップをできるだけ多く手に入れるためにNvidiaに行列を作ることを示唆している

。

一言で言えば最も重要なこと

- Nvidia presents the new Blackwell architecture for generative AI at GTC 2024.

- B200チップはH100およびGH100フラッグシップに代わるもので、パフォーマンスとエネルギー効率が向上しています。

- GPUは4nm製造プロセスをベースとし、2080億トランジスタを搭載。

- GB200スーパーチップはGraceプロセッサーとBlackwell GPUを組み合わせ、極めて高い演算能力を提供します。

X。

NvidiaB200の技術データ

このGPUは、台湾のチップメーカーTSMCがBlackwellのために設計した特別な4nm製造プロセスである4NP製造プロセスに基づいて開発されています

。

B200自体はデュアルダイ設計です。2つの内蔵チップは、スライド・トゥ・ダイ・リンクを介して最大10Tバイト/秒の速度で通信するため、AMDが主に使用するMCM(マルチチップモジュール)プロセスと比較して不利な点はありません。

B200カードには合計2080億トランジスタが搭載されています。Nvidiaによると、理論上の演算能力は以下の通りです。

- FP8:最大20ペタFLOPS

- FP16:最大10ペタFLOPS

- FP32:最大5ペタフロップス

Huang氏によると、この結果、AIのトレーニング性能は約4倍、AIの推論性能は約30倍になるという。一方、エネルギー効率は25分の1に改善される。

メモリ面では、Nvidia B200は192GByteのHBM3eメモリで動作し、帯域幅は最大8TByte/sとなる。

“グレース・ブラックウェル “が新しいスーパーチップに

この新しいチップは、GB200と呼ばれる「Grace Blackwell」スーパーチップの基礎となるもので、主にNvidia独自のNVL72コンピュータやカスタマイズされたソリューションに使用される予定です

。

その名の通り、GB200 Grace Blackwellは、Arm社の72 Neoverse V2コアを搭載したGraceプロセッサーと、B200グラフィックスチップ2個からなるハイブリッドソリューションです。

上記のNVL72コンピュータでは、36個のGrace CPUが72個のBlackwell GPU(つまり144個のBlackwellダイ)と共に使用されており、その結果、次のような非常識な技術データが得られます。

- Processor: 2,592 ARM Neoverse V2コア

- Memory: 最大17 TByte LPDDR5X RAM

- 72 Blackwell GPU:13.5 TByte HBM3eメモリ搭載

- FP4演算能力:最大1,440ペタフロップス

- FP8演算能力:最大720ペタフロップス

- FP16演算能力:最大360ペタフロップス

:最大360ペタフロップス

NVLinkのおかげで、毎秒最大130TByteの帯域幅が約束され、NVL72スーパーコンピュータは1つの巨大なグラフィックプロセッサのように動作するはずです

。

NVLinkドメインには最大576個のGPUを接続することが可能で、Huang氏によれば、その総計算能力は、数兆個のパラメータを持つ大規模な言語モデル(LLM)を処理するのに十分であるとのことだ。

想定される消費電力はそれに応じて高く、GB200スーパーチップ1個で最大2,700ワットを必要とすると言われている。

最初のビジネス顧客はすでに列をなしており、AIプラットフォームは年内にビジネスパートナー向けに提供されるはずだ。NvidiaはAWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructureなどのクラウドプロバイダーについて明確に言及しており、これらのプロバイダーは当然のことながらBlackwellアーキテクチャに関心を示している。Huang氏が説明するように、NvidiaはBlackwellで「会社史上最も成功した立ち上げ」に直面している。