Zoals verwacht presenteerde Nvidia op de GTC 2024 de nieuwe Blackwell-architectuur. Met de B200 chip en het GB200 platform betreedt de fabrikant nieuwe gebieden

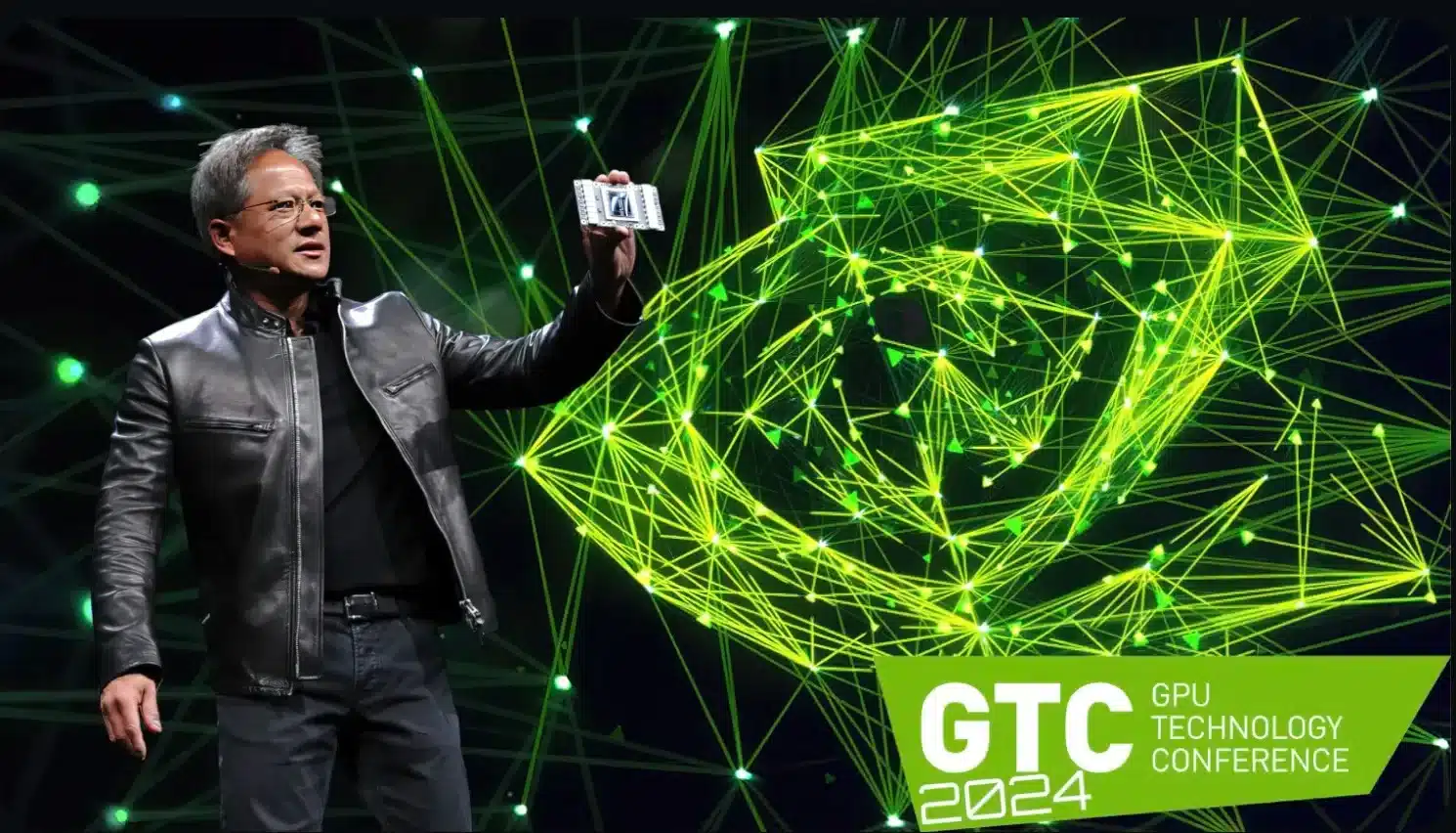

Zoals verwacht presenteerde Nvidia maandagavond de nieuwe Blackwell-architectuur tijdens de lopendeGTC 2024 (GPU Technology Conference)en beloofde daarmee nieuwe standaarden te zetten.

Zoals Nvidia CEO Jensen Huang terecht uitlegde, is dit bedoeld om een “nieuw tijdperk van generatieve AI” in te luiden. De speerpunt hiervan is de B200-chip, die de vorige H100- en GH100-vlaggenschepen van de Hopper-generatie vervangt

De indrukwekkende technische specificaties (zie hieronder) suggereren dat grote klanten zoals Amazon en Microsoft met de bijbehorende vraag en budget in de rij zullen staan bij Nvidia om zoveel mogelijk van deze chips te krijgen.

De belangrijkste dingen in een notendop

- Nvidia presenteert de nieuwe Blackwell-architectuur voor generatieve AI tijdens GTC 2024.

De GB200 superchip combineert Grace-processors en Blackwell GPU’s en biedt extreem hoge rekenkracht.

Technische gegevens van de Nvidia B200

De B200 zelf is een dual-die ontwerp. De twee ingebouwde chips communiceren via een slide-to-die link met een snelheid van maximaal 10 TByte per seconde en zouden daarom geen nadelen moeten hebben ten opzichte van het MCM (Multi Chip Module) proces, dat voornamelijk door AMD wordt gebruikt.

Er zitten in totaal 208 miljard transistors in de B200-kaart. Volgens Nvidia ziet de theoretische rekenkracht er als volgt uit:- FP8: tot 20 PetaFLOPS

- FP16: tot 10 PetaFLOPS

- FP32: maximaal 5 PetaFLOPS

Aan de geheugenkant werkt de Nvidia B200 met 192 GByte HBM3e-geheugen, de bandbreedte zou tot 8 TByte/s moeten zijn.

“Grace Blackwell” als nieuwe superchip

De nieuwe chip vormt ook de basis voor de “Grace Blackwell” superchip genaamd GB200, die voornamelijk zal worden gebruikt in Nvidia’s eigen NVL72 computer en maatwerkoplossingen.

In de hierboven genoemde NVL72 computer worden 36 van de Grace CPU’s gebruikt samen met 72 Blackwell GPU’s (en dus 144 Blackwell chips), wat resulteert in de volgende waanzinnige technische gegevens:

- Processor: 2.592 ARM Neoverse V2-kernen

- Geheugen: Tot 17 TByte LPDDR5X RAM

- 72 Blackwell GPU’smet 13,5 TByte HBM3e-geheugen

- FP4 rekenkracht: tot 1.440 PetaFLOPS

Rekenkracht - FP8: tot 720 PetaFLOPS

- FP16 rekenkracht: tot 360 PetaFLOPS

Dankzij NVLink, dat tot 130 TByte per seconde aan bandbreedte belooft, zou de NVL72 supercomputer zich moeten gedragen als één enkele enorme grafische processor

Er kunnen in totaal 576 GPU’s worden aangesloten in zo’n NVLink-domein – volgens Huang moet de totale rekenkracht voldoende zijn om grote taalmodellen (LLM’s) met triljoenen parameters te verwerken

Het veronderstelde stroomverbruik is navenant hoog: een enkele GB200 superchip zou tot 2700 watt nodig hebben.

De eerste zakelijke klanten staan al in de rij Het AI-platform moet in de loop van het jaar beschikbaar zijn voor zakelijke partners. Nvidia noemt expliciet cloudproviders zoals AWS, Google Cloud, Microsoft Azure en Oracle Cloud Infrastructure, die niet verrassend interesse tonen in de Blackwell-architectuur. Zoals Huang uitlegt, staat Nvidia met Blackwell voor de “meest succesvolle lancering in de geschiedenis van het bedrijf”.