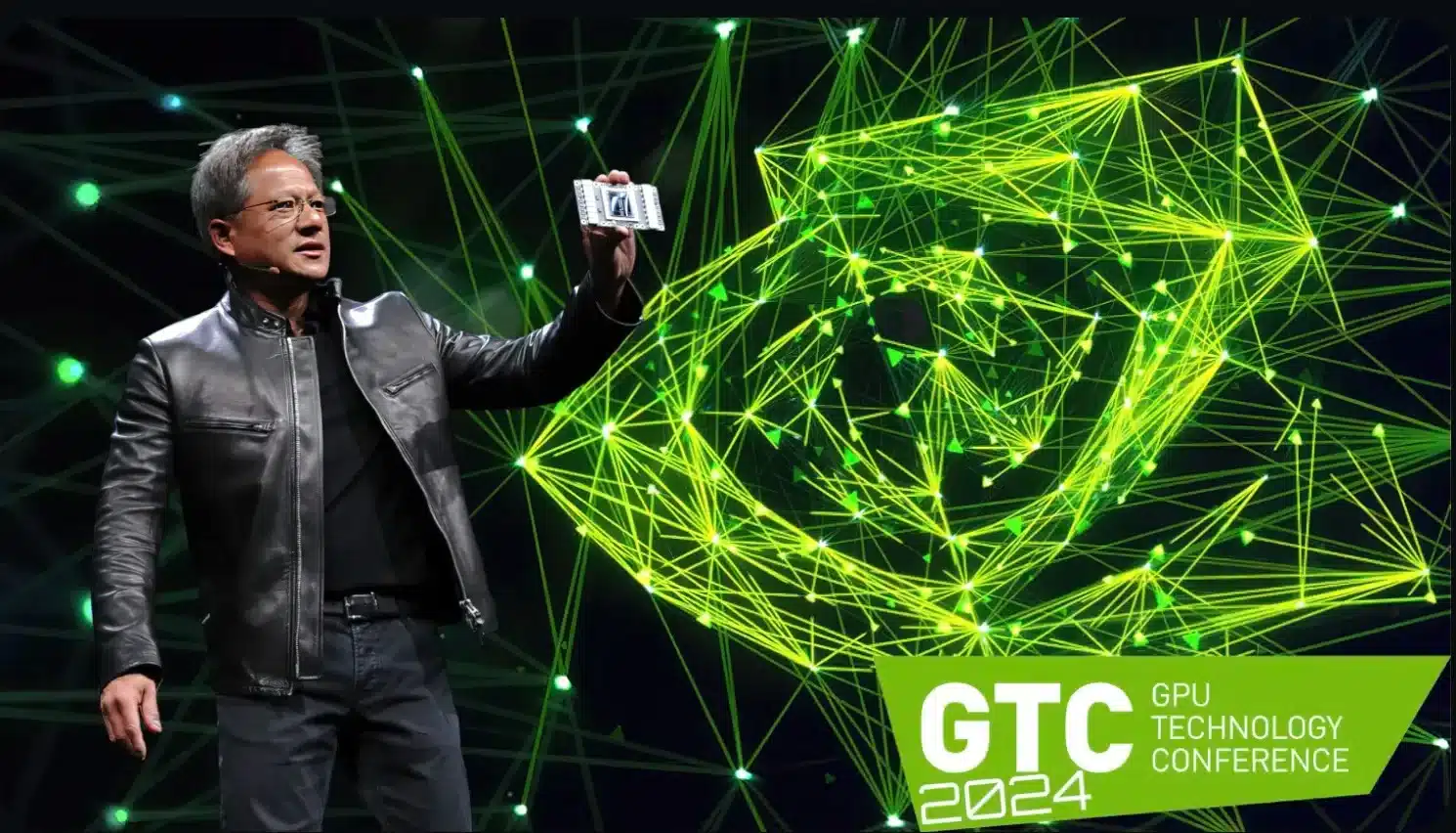

不出所料,Nvidia 在 GTC 2024 上展示了全新的 Blackwell 架构。凭借 B200 芯片和 GB200 平台,该制造商正在进入新的领域

。

不出所料,Nvidia 在周一晚举行的 GTC 2024(GPU 技术大会)上展示了全新的 Blackwell 架构,并承诺将设立新的标准

。

正如英伟达首席执行官黄仁勋(Jensen Huang)所解释的那样,这将预示着一个 “生成式人工智能的新时代”。B200 芯片是这一切的先驱,它取代了之前 Hopper 时代的旗舰产品 H100 和 GH100

。

令人印象深刻的技术规格(见下文)表明,亚马逊和微软等有相应需求和预算的大客户将在 Nvidia 排队,以获得尽可能多的这些芯片。

最重要的事情一言以蔽之

- Nvidia在GTC 2024上展示用于生成式人工智能的全新Blackwell架构。

- B200芯片取代了H100和GH100旗舰芯片,并提高了性能和能效。

- 图形处理器采用 4 纳米制造工艺,拥有 2080 亿个晶体管。

- GB200 超级芯片结合了 Grace 处理器和 Blackwell GPU,具有极高的计算能力。

Nvidia B200

的技术数据

该 GPU 是基于 4NP 制造工艺开发的,这是台湾芯片制造商台积电为 Blackwell 设计的一种特殊 4 纳米生产工艺。

B200本身采用双芯片设计。两个内置芯片通过滑动到芯片链接进行通信,速度高达每秒 10 TByte,因此与 AMD 主要采用的 MCM(多芯片模块)工艺相比,应该没有任何劣势。

- FP8:高达 20 千亿次FLOPS

- FP16: 高达 10 PetaFLOPS

- FP32: 高达 5 PetaFLOPS

- 处理器:2,592 个 ARM Neoverse V2 内核

- 内存: 高达 17 TByte LPDDR5X RAM

- 72 Blackwell GPU配备13.5 TByte HBM3e内存

- FP4计算能力:高达1,440PetaFLOPS

- FP8计算能力:高达720PetaFLOPS

- FP16计算能力:高达360PetaFLOPS

: 高达 5 PetaFLOPS

根据 Huang 的说法,这将使人工智能训练性能提高约 4 倍,人工智能推理性能提高约 30 倍。同时,能效也将提高 25 倍。

在内存方面,Nvidia B200 采用 192 GByte HBM3e 内存,带宽可达 8 TByte/s。

“格蕾丝-布莱克威尔 “作为新的超级芯片

新芯片还构成了名为GB200的 “Grace Blackwell “超级芯片的基础,该芯片将主要用于Nvidia自己的NVL72计算机和定制解决方案。

正如其名,GB200 格蕾丝-布莱克韦尔是一种混合解决方案,由一个带有 72 个 Neoverse V2 内核的格蕾丝处理器和两个所示的 B200 图形芯片组成。

在上述 NVL72 计算机中,使用了 36 个格雷斯 CPU 和 72 个布莱克韦尔 GPU(因此有 144 个布莱克韦尔芯片),从而产生了以下疯狂的技术数据:

。

得益于 NVLink(承诺每秒高达 130 TByte 的带宽),NVL72 超级计算机应能像单个大型图形处理器一样运行

。

在这样一个NVLink域中,总共可以连接多达576个GPU–根据Huang的说法,总计算能力应足以处理具有数万亿个参数的大型语言模型(LLM)。

假定的功耗也相应较高:据说单个 GB200 超级芯片需要高达 2,700 瓦的功率。

第一批商业客户已经在排队等候。Nvidia 明确提到了 AWS、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 等云提供商,他们对 Blackwell 架构表现出兴趣也就不足为奇了。正如Huang所解释的,Nvidia正面临着Blackwell “公司历史上最成功的发布”。